Einzelne Seiten für Suchmaschinen sperren

Um bestimmte Seiten von der Indizierung auszuschließen (also für Suchmaschinen zu "sperren"),

gibt es den sogenannten Robots Exclusion Standard.

Kurz gesagt ist alles was Sie machen müssen, eine Datei namens "robots.txt" zu erstellen, darin die von Ihnen nicht gewünschten zu indizierenden Seiten vermerken und diese "robots.txt"-Datei in den Hauptordner Ihrer Website auf den Server hochzuladen.

Beispielsweise könnte eine "robots.txt"-Datei so aussehen:

User-agent: *

Disallow: /intern.html

Disallow: /backups/

Disallow: /privat/familie/geburtstage.html

Dadurch sperren Sie die Datei "intern.html" im Hauptverzeichnis, alle Dateien im Ordner "backups", sowie die Datei "geburtstage.html" im Unterordner "privat/familie" von der Indizierung durch Suchmaschinen. D.h. wenn Benutzer später nach Begriffen bei Google suchen, so werden niemals die ausgeschlossenen Seiten in der Suchergebnisliste angezeigt.

So erstellen Sie eine "robots.txt"-Datei

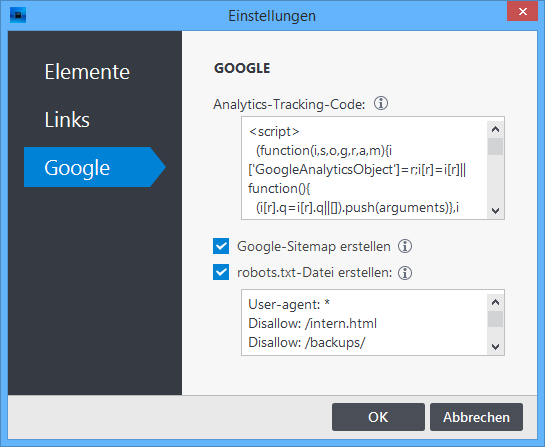

- Klicken auf "Website | Einstellungen".

- Wählen Sie die Gruppe "Google".

- Aktivieren Sie das Kästchen neben "robots.txt erstellen".

- Schreiben Sie die gewünschten Ausschluss-Direktiven in das darunterliegende Feld.

- Klicken Sie auf "OK".

Nun wird die Datei bei jedem Veröffentlichen Ihres Webprojekts automatisch erstellt und auf dem Webserver geladen.